“这次,我会给大家带来惊喜,和一些大家可能猜不到的东西。我保证我会谈论人工智能,我们会谈论机器人技术。”这是NVIDIA公司创始人兼CEO黄仁勋在开场时的承诺。

事实也确实如此,黄仁勋演讲一开始,就定下了“颠覆历史”的“基调”。他强调,计算机行业与NVIDIA自身的重塑在于计算模式的根本性转变——从以独立设备为中心,转向以“AI工厂”为中心,数据中心则成为其PG电子 PG平台“计算单元”。

如同历史上的电力和互联网,AI正成为驱动现代社会运行的第三种必要基础设施。“这种新型基础设施建立在前两个基础设施之上。“这是更智能的基础设施。” 黄仁勋坚信,这种智能基础设施将在未来十年内渗透到全球各个地区、行业、企业,成为无处不在的核心动力。

这种新型基础设施的核心特征在于,将数据中心转变为能够生产高附加值“智能”的“AI工厂”。黄仁勋用一个形象的比喻来阐释其本质:这些工厂消耗能源,生产的却是*价值的token。AI工厂的生产效率将成为新的生产力衡量标准。

“很快,我们将讨论每小时生产多少个token。” 黄仁勋坦言。这意味着,AI工厂将成为专门用于通过计算从海量数据中提炼、生成、处理和传播智能的“生产力中心”。

驱动NVIDIA “AI工厂”高效运转的引擎,正是其新一代Blackwell架构。

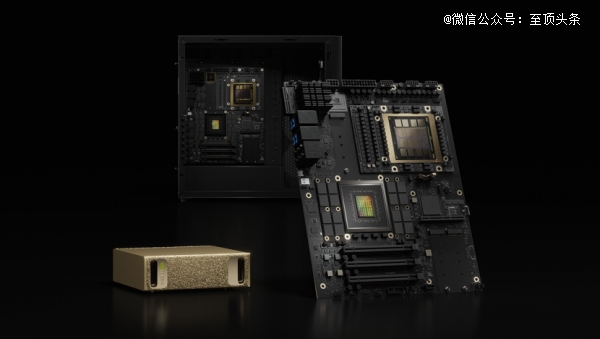

此次基于Blackwell架构的产品,覆盖从超大规模计算到专业可视化、从数据中心到边缘设备的多层次产品线全面亮相,展现了其强大的性能和广泛的应用潜力。

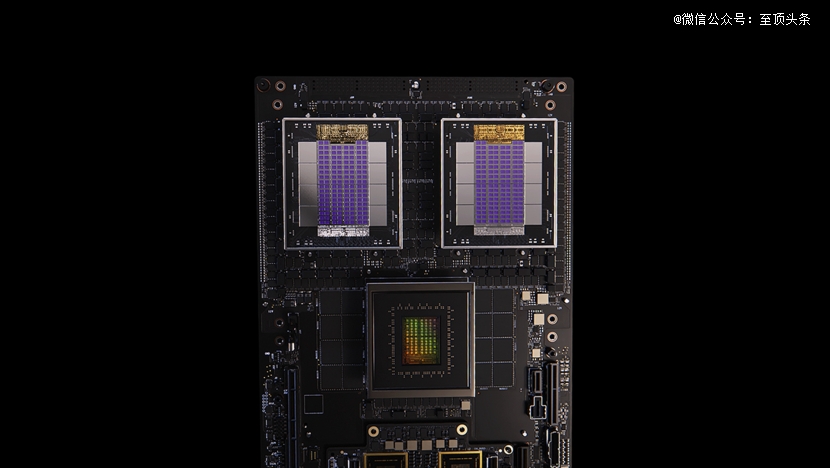

对于构建大规模的AI工厂,Grace Blackwell超级芯片(NVIDIA GB200)及其最新的升级版NVIDIA GB300是核心计算单元。通过NVIDIA独有的NVLink互连技术,实现了将多个GPU整合为一个巨型计算单元的能力。

NVLink可提供高达7.2 TB/s的带宽,被誉为“世界上最快的交换机”。在一个机架内部署9个NVLink交换机,通过NVLink Spine连接,总带宽可高达130 TB/s。这种惊人的互连能力使得机架内的72个Blackwell GPU能够作为一个统一的计算资源池高效协同工作,实现前所未有的计算性能。

黄仁勋强调了其强大的数据传输能力:“移动的数据流量比整个互联网的峰值流量还要多。”而这种设计使得整个机架如同一个巨大的“PC主板”,实现了GPU的完全解耦和灵活调度。

NVIDIA GB300作为NVIDIA GB200的升级版本,在保持架构一致性的基础上,进一步提升了关键性能。黄仁勋介绍,GB300的推理性能提高了1.5倍,一个GB300系统的性能,大约相当于18000个Volta GPU的Sierra超级计算机,这淋漓尽致地展现了NVIDIA在计算性能上的指数级飞跃,显著超越了传统的摩尔定律。

Blackwell架构的强大能力并不仅限于超大规模数据中心。NVIDIA正积极将其引入企业和专业领域。NVIDIA推出的RTX Pro Blackwell服务器,搭载全新的RTX Pro 6000 Blackwell服务器版GPU。这些服务器专为企业数据中心设计,采用风冷散热,注重能效,能够加速各类企业级AI工作负载,包括生成式AI、机器人模拟、数字孪生和工程应用。这些服务器已开始接受预订,并预计于今年夏天由众多服务器制造商推出。

此外,NVIDIA还全面更新了面向专业工作站和笔记本电脑的RTX Pro GPU系列。全新的RTX Pro 5000、4000、3000、2000、1500系列GPU,将Blackwell架构的强大AI和图形处理能力带给数百万专业人士,赋能其在桌面和移动平台上进行复杂的设计、模拟和AI开发。

黄仁勋透露,搭载新一代RTX Pro GPU的专业笔记本电脑预计也将于今年夏天上市。

黄仁勋特别提到了面向消费者和专业可视化的GeForce产品线,他以微星新款笔记本电脑为例,这款笔记本搭载了RTX 5060 GPU,并着重强调了深度学习超采样DLSS等AI技术,在实现高分辨率实时光线追踪方面的关键作用。

通过神经渲染技术,AI能够仅计算低至十分之一的少量像素,然后预测并生成其余像素,从而大幅提升渲染性能,实现逼真流畅的图形效果。

Blackwell架构正从云端到边缘、从数据中心到桌面产品全面渗透,意味着其强大的AI计算能力将惠及各类用户,加速AI在各行各业的应用。

诚然,NVIDIA也认识到,并非所有用户都需要完全由NVIDIA 硬件构建的AI系统,企业和特定用户可能希望将NVIDIA 的GPU与其他计算资源结合使用。为此,NVIDIA 推出了NVLink-Fusion技术,旨在构建一个更加开放和灵活的AI基础设施生态。

黄仁勋宣布:“NVIDIA NVLink-Fusion,能够帮助用户构建半定制的AI基础设施。” 他指出,NVLink-Fusion的灵活性,允许合作伙伴通过NVIDIA 的高速NVLink互连网络集成他们自己的CPU或其他定制加速器。

目前,NVIDIA正与包括富士通、高通等CPU厂商,以及Marvell、MediaTek等合作伙伴紧密合作,共同将NVLink-Fusion技术集成到他们的产品中。

黄仁勋强调说:“现在,我们正让这一体系变得更加的灵活和开放,可供各方轻松进行集成。”

其实,NVLink-Fusion的推出,不仅展现了NVIDIA在保持自身核心技术*地位的核心竞争力之一,也表明了其与合作伙伴共同构建更加多样化、定制化的AI基础设施生态系统的开放态度,旨在共同拓展AI的市场规模和应用范围。

据NVIDIA透露,除了目前公布的合作伙伴,NVIDIA预计,随着技术的进一步推广,这一生态系统将持续壮大,甚至不排除未来与传统竞争对手展开合作的可能性。

将AI能力无缝集成到企业现有的IT架构和业务流程中,是NVIDIA 在COMPUTEX上强调的核心话题之一。而这需要从硬件平台到软件栈,再到应用模式的全面创新。

NVIDIA 推出的RTX Pro企业级Omniverse服务器,便是为企业IT环境构建的通用AI平台。这款服务器兼容传统的x86工作负载和虚拟化管理程序(如VMware、IBM Red Hat),并支持Kubernetes等编排工具,使得企业IT部门能够以熟悉的方式管理AI资源。

黄仁勋提到,这款服务器不仅兼容现有架构,更具备强大的AI能力,是“企业AI代理的计算机”,能够处理包括文本、图形、视频在内的多模态AI工作负载,尤其在推理性能上表现突出。

值得注意的是,其在DeepSeek-V2模型上相对于现有H100的显著性能提升,证明了其作为企业AI平台的强大实力。

企业数据的价值是AI应用的重要基础,尤其是大量的非结构化数据。黄仁勋指出,区别于传统结构化数据查询,AI需要理解非结构化数据的“语义”和“意义”。为了帮助企业挖掘这些数据的价值,NVIDIA 推出了AI数据平台。

NVIDIA AI数据平台基于新型存储系统和NVIDIA AI-Q查询系统,能够对非结构化数据进行高效的嵌入、索引和语义搜索。

黄仁勋提到,NVIDIA 正与Vast、戴尔、日立、IBM、NetApp等存储厂商合作,将NVIDIA 的AI模型和软件栈集成到他们的存储解决方案中。他强调,未来的存储服务器需要配备GPU,以便在数据存储端进行AI处理,例如嵌入和索引,从而实现对非结构化数据的快速、智能查询。

“AI数据平台使得企业能够利用AI发掘其90%的非结构化数据中的价值,通过自然语言的方式与企业知识库互动。”黄仁勋强调说。

AI Agent 被黄仁勋视为下一代企业应用的核心。他表示,AI Agent是能够感知、理解、规划和使用工具的“数字员工”,可以执行复杂任务,甚至可以与人类或其他AI协作。

事实上,在全球劳动力短缺的背景下,AI Agent 将成为企业重要的“补充力量”和“后备军”。据悉,目前,NVIDIA 已经在自身的软件开发中广泛使用AI Agent,并计划将其推广到所有NVIDIA 工程师。

为了支持企业大规模部署AI Agent,NVIDIA 构建了一套AI Ops工具和库,并与CrowdStrike、Dataiku、DataRobot等合作伙伴共同构建企业级AI Agent 生态系统,帮助企业进行AI代理的开发、训练、部署、管理和安全防护。

未来企业IT管理团队,将由人类员工和AI代理共同组成,而NVIDIA提供的平台与工具,则支持这种模式。这是NVIDIA 的愿景。

万亿“物理AI”之局:NVIDIA用Omniverse和Isaac“串联”工业数字孪生和具身智能

然而,NVIDIA 对于 AI 的愿景远不止于此。AI的力量正深刻影响物理世界,NVIDIA 通过Omniverse和Isaac平台,连接物理与数字世界,推动工业AI和机器人技术发展。

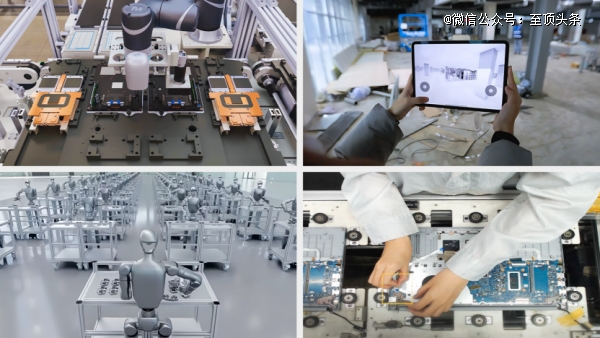

事实上,台积电、富士康、纬创、和硕、广达电脑、仁宝和技嘉等多家*制造业公司,都在大规模使用Omniverse来构建工厂生产线的数字孪生,以优化制造流程、模拟测试和员工培训。

例如,台积电利用Omniverse和AI工具生成晶圆厂的3D布局,模拟复杂的管道系统,这极大地缩短了规划时间和成本。而和硕、纬创和广达电脑则在物理设施建设之前,先在虚拟世界中规划生产线布局。

这些数字孪生同时也是物理AI的“训练场”。目前,许多企业利用这些数字孪生在虚拟环境中训练和测试各类机器人。

值得注意的是,Omniverse的应用范畴也扩展到了城市层面。目前,中国台湾地区的高雄市,正在利用数字孪生来模拟城市运行,构建AI代理进行交通管理和公共安全监控。

“数字孪生正是实现软件定义制造的关键所在,更是迎接具身智能未来重要引擎。”黄仁勋如是说。

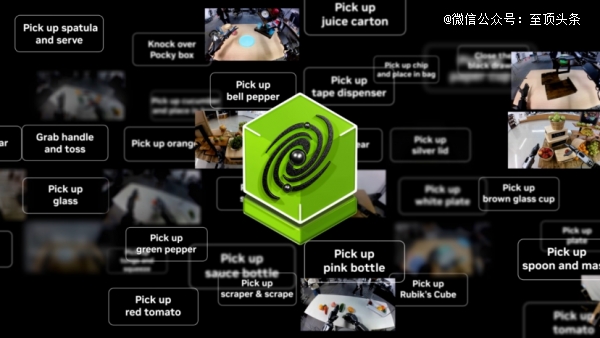

具身智能是黄仁勋重点关注的领域,他认为这是“下一个万亿美元的产业”。在加速具身智能的发展层面,此次NVIDIA的Isaac机器人平台,也发布了重要的更新。

机器人开发面临着数据挑战。黄仁勋直言道“机器人需要在真实世界的数据上学习,这既昂贵又耗时。”为了解决这个问题,NVIDIA 提出了利用 AI“梦想”数据的方法,并推出了 Isaac GR00T Dreams blueprint(蓝图,可以理解为工作流)。

该“蓝图”基于 Cosmos物理 AI基础模型,通过对大量人类示教数据进行微调后,可以在虚拟环境中生成大量的合成动作轨迹数据,从而大幅减少人工数据采集的需求。据了解,NVIDIA 的研究团队通过这种方法,用36小时生成的合成数据量,相当于人工采集 3 个月的数据量。

黄仁勋认为,为了让具身智能成为现实,既需要 AI,更需要 用 AI 来教导 AI,而利用合成数据生成技能来训练机器人,正是实现这一目标、推动机器人发展的关键。而NVIDIA 正积极构建实现这一愿景所需的全栈工具和平台。

据透露,该模型将于今年 6 月在 Hugging Face 上开源,进一步推动机器人研究和应用。

此外,NVIDIA 推出的机器人处理器 JetsoPG电子 PG平台n Thor,还将用于自动驾驶汽车和人形机器人系统。Isaac 操作系统则作为机器人的运行时环境,为机器人提供强大的软件支持。据NVIDIA透露,Isaac Sim5.0和 Isaac Lab2.2作为机器人训练和模拟环境,将通过集成 Newton物理引擎,以提供更高保真度的模拟,从而提升训练效果。

正如黄仁勋总结的那样,推动具身智能和机器人技术发展,构建物理 AI 机器人,离不开 NVIDIA 提供的全栈解决方案。这套强大的基础方案中,包含了用于模拟学习的 Omniverse 平台和用于部署的 Jetson 平台。而至关重要的模型训练环节,则由DGX 系列提供支持。

为满足日益增长的AI开发需求并简化算力获取流程,NVIDIA对DGX 系列进行了重要拓展和更新,推出了 DGX Cloud Lepton 平台、DGX Spark 紧凑型AI超算 以及新版本的 DGX Station 高性能工作站。这些新品旨在从不同层面解决开发者在获取和管理AI计算资源方面遇到的挑战。

针对全球GPU资源分散、开发者难以统一管理和获取的痛点,DGX Cloud Lepton 平台。作为创新的AI中心云软件平台,旨在构建一个连接开发者与全球GPU提供商的AI算力市场。通过该平台,开发者能够便捷地访问位于不同云区域的GPU资源,有效解决了资源分布不均的问题。

Lepton 平台的核心优势在于其提供的统一控制平面,这极大地简化了跨多云环境的AI工作负载管理。平台支持自动扩展和跨区域调度功能,使得开发者可以根据实际需求灵活选择和调配最合适的计算资源,无需在不同云平台之间进行复杂的协调。

据悉,Lepton 平台由 NVIDIA 托管并部署在云服务提供商的网络中,其核心目标是填补全球GPU供应与AI开发者之间缺失的关键软件层。其能提供更加便捷高效的AI算力获取方式,并能将全球分散的GPU资源整合成一个虚拟的“全球AI工厂”。

值得一提的是,Lepton 能够访问所有类型的 NVIDIA GPU,包括最新的Blackwell 系列。目前,Lepton 平台由 NVIDIA 托管,并与包括嘉达、富士康、软银、Furnace 和 GMI 等在内的合作伙伴共同提供服务。

除了平台级解决方案,NVIDIA 还面向AI原生开发者推出了一款紧凑型AI超算——DGX Spark。 DGX Spark 旨在满足开发者在进行原型验证和早期开发阶段所需的桌面级强大计算能力。该款产品拥有1 Petaflop(每秒钟进行1千万亿次的数学运算)的性能,且体积小巧,可作为个人AI云使用。

同时更新的还有 DGX Station,其是专为需要强大桌面AI能力的用户设计的高性能工作站。新版本的 DGX Station能够在标准电力条件下运行万亿参数模型,为用户提供了接近数据中心级的桌面解决方案。“这款产品足以满足用户运行大型AI模型的需求,将强大的AI计算能力带到桌面。”黄仁勋直言说。

总而言之,NVIDIA以DGX Cloud Lepton为经纬,编织出一张连接与管理的网络,将散落的计算节点汇聚成一个可触及的整体意识。同时,DGX Spark与新版DGX Station则构筑了智能涌现的个人基础。从个人的思考到更高性能的创新,提供了多层级的形态。

与其说是简单的产品发布,不如看作是NVIDIA对当前AI发展核心矛盾——即强大计算能力与普遍可及性之间的鸿沟——所提出的系统性回应。

NVIDIA 的核心实力不仅在于其强大的计算性能,更关键的是其在软件库平台和生态系统上的全栈布局。其核心竞争力尤其体现在 CUDA-X 库,该库通过优化各领域的算法,极大地加速了广泛的应用并开辟了新的市场。

NVIDIA 坚信,通过软件算法优化所能实现的效果,甚至能够超越单纯的硬件性能提升。

此外,NVIDIA 庞大的合作伙伴生态系统是其成功的另一关键要素。通过与数百家合作伙伴紧密协作,将自身的技术能力转化为实际的应用解决方案。这种紧密的生态合作模式使得 NVIDIA 能够快速地将技术推向市场,从而满足不同行业的多样化需求。

黄仁勋认为,当前正处于一个全新的产业开端,这是一个千载难逢的巨大机遇。公司期待与合作伙伴共同努力,构建 AI 工厂、企业 AI 机器人等未来的产业支柱。

为了巩固其深耕市场的承诺,黄仁勋宣布将建立一个新的大型办公区——“Constellation”。NVIDIA 指出,在软件定义制造方面正引领潮流,并且其制造业优势使其在工业 AI 机器人领域具备独特的优势,这也是设立Constellation的战略考量之一。

黄仁勋在COMPUTEX上的演讲,更像是一份关于人工智能时代未来蓝图的宣示。

核心在于将未来计算模式进行根本性重塑——从以独立设备为中心,跃迁至以生产高附加值“智能”为使命的“AI工厂”为核心。数据中心被重新定义为生产力的度量单位将很快以每小时生产的“token”数量来衡量,这是一种深刻的认知转变。

这一宏图的实现,依赖于NVIDIA 强大的技术堆栈。全新的Blackwell架构是驱动AI工厂的引擎,通过NVLink等高速互联技术,打破硬件单元界限,构建巨型计算资源池。更具战略意义的是,NVLink-Fusion技术的推出,表明NVIDIA 正走向更加开放的生态,允许合作伙伴将其芯片与NVIDIA GPU深度集成,共同拓展AI基础设施的多样性。

NVIDIA更是积极将AI能力无缝融入企业现有IT架构,通过AI数据平台解锁非结构化数据的巨大价值,并将AI Agents视为未来的“数字员工”,推动企业生产力的根本性飞跃。而连接数字世界与物理世界的Omniverse和Isaac平台,则指向了更远大的愿景:构建工业数字孪生,以及黄仁勋眼中万亿级市场的具身智能。通过模拟训练和AI“梦想”数据等创新方式,NVIDIA 正努力弥合虚拟与现实的界限,让智能真正“行走”于物理世界。

事实上,NVIDIA 正通过全栈的技术、多层级的硬件形态,以及广泛的生态协作,绘制着一个由AI深度渗透并重塑物理与数字现实的未来蓝图。这是技术的飞跃,更是一种关于智能、生产力和存在形态思考与实践。

NVIDIA 正以前所未有的演进速度,成为这个由AI驱动未来世界的“首席建筑师”。